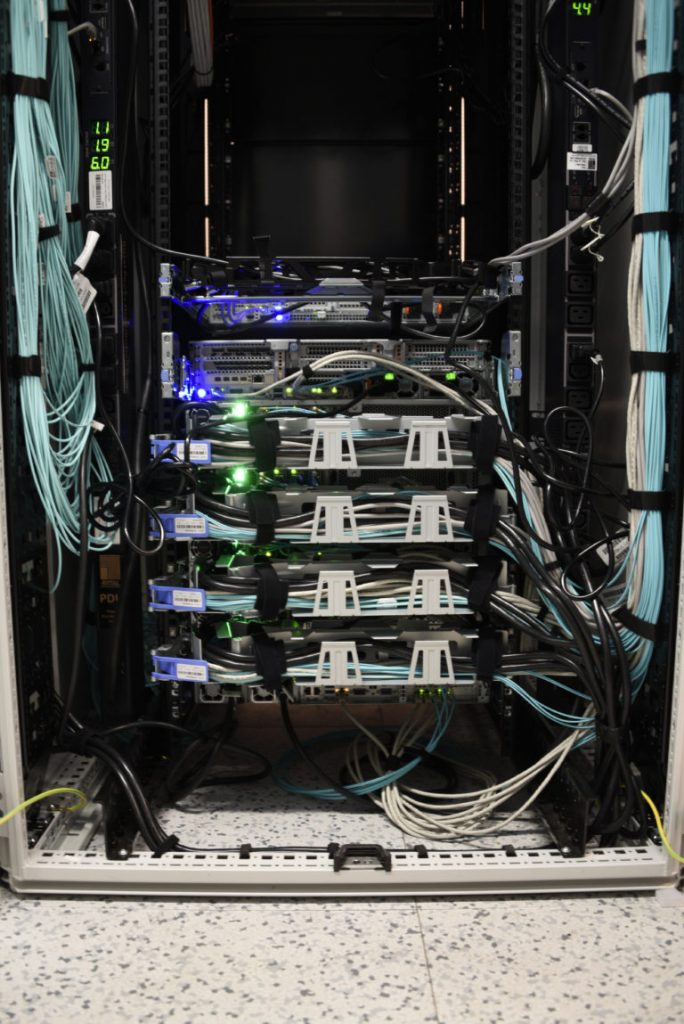

To nasz superkomputer o wysokiej wydajności (HPC, High Performance Computing) realizujący wielkoskalowe obliczenia, rozszerzone o zadania sztucznej inteligencji AI (Artificial Intelligence) i wysokowydajnej analizy danych (HPDA, High Performance Data Analytics), adresujące zagadnienia modelowania i symulacji, zjawisk i procesów, w oparciu o duże zbiory danych.

Kliknij tutaj by przejść do pierwszej części opisu CATO

W pierwszej części wskazane zostały parametry podstawowych elementów składających się na CATO. Uzupełnieniem warstwy sprzętowej jest stos oprogramowania do zarządzania zadaniami obliczeniowymi w klastrze oraz tworzeniem środowisk wykonawczych dla zadań z zakresu uczenia maszynowego, które stanowią LSF (ang. Load Sharing Facility) oraz Spectrum Conductor. Dzięki kontroli dostępu opartej na rolach możliwe jest budowanie, uruchamianie i wdrażanie wielu różnych aplikacji działających równocześnie w przestrzeni klastra. Istotnym elementem warstwy programowej jest Watson Machine Learning Accelerator stanowiący kompleksowe środowisko dostarczające wywodzące się ze świata otwartego oprogramowania języki, biblioteki i frameworki, m.in. takie jak TensorFlow, Keras, Caffe, PyTorch, ekosystem języka Python oraz rozwijane w laboratoriach IBM biblioteki takie jak Spectrum MPI, czy rozszerzenia do bibliotek głębokiego uczenia jak LMS (ang. Large Model Support) czy DDL (ang. Distributed Deep Learning). Narzędzia te w świecie Data Science z powodzeniem stosowane są do wykonywania zadań analizy danych, a zoptymalizowane na platformę sprzętową umożliwiają prowadzenie wysokowydajnej analizy danych i obsługi modeli i rozwiązań wykorzystujących rozproszone głębokie uczenie, które pozwala korzystać z modeli o większej rozdzielczości. Uzupełnieniem stosu programowego są dostępne w ramach systemu kompilatory C/C++/Fortran posiadające implementację standardu OpenMP, biblioteki MPI oraz zrównoleglone biblioteki matematyczne Parallel ESSL.

CUDA W CATO

Od czasu udostępnienia w 2006 roku technologii CUDA (ang. Compute Unified Device Architecture), możliwe stało się stosunkowo łatwe rozwijanie oprogramowania, które po kompilacji wykonuje się na heterogenicznej platformie obliczeniowej z CPU i GPU – na CPU kod sekwencyjny, na GPU kod równoległy (NVIDIA CUDA – host, device). Oprócz tego pojawiły się biblioteki dziedzinowe adresujące problemy obliczeniowe wielu dziedzin nauki. Dostępna dzięki NVIDIA CUDA moc obliczeniowa na heterogenicznych platformach otworzyła także drogę do intensyfikacji badań w ramach systemów sztucznej inteligencji, w szczególności wokół zagadnień deep learningu. W tym segmencie firma Nvidia w znaczący sposób zaznacza swoją obecność rozwijając kolejne generacje układów sprzętowych i towarzyszące im oprogramowanie. Wybór tej technologii przy budowie CATO był oczywisty.

PRACA Z CATO

Praca z systemem CATO w przestrzeni Data Science minimalizuje próg wejścia pozwalając na zachowanie przyzwyczajeń badawczych poprzez stosowanie narzędzi i rozwiązań (takich jak Jupyter Notebook, Zeppelin, Anaconda), które zdobyły ugruntowaną pozycję w środowisku zarówno naukowym jak i biznesowym. Tworzą one przyjazne środowisko pracy i udostępniają wyżej wymienione narzędzia, technologie i zasoby klastra.

System CATO jest platformą, która architektonicznie – w zakresie komponentów sprzętowych i programowych – odpowiada dwóm najszybszym superkomputerom na świecie – Summit i Sierra.

CATO JEST JUŻ DOSTĘPNY. SKONTAKTUJ SIĘ Z NAMI, BY Z NIEGO SKORZYSTAĆ

10 stycznia 2022

10 stycznia 2022